|

|

BMe Kutatói pályázat |

|

Kandó Kálmán Doktori Iskola

BME Közlekedés- és Járműmérnöki Kar, Anyagmozgatási és Logisztikai Rendszerek Tanszék

Témavezető: Dr. Szirányi Tamás

Autonóm gépek LIDAR alapú látása szélsőséges esetekben

A kutatási téma néhány soros bemutatása

Autonóm járművek és mobilgépek jelentős fejlődése és térhódítása mutatkozik napjainkban, mind a közutakon, mind ipari környezetben. Ezen gépek nagyon gyakran fel vannak szerelve környezetérzékelésre alkalmas szenzorokkal, többek között LIDAR-ral. Ezen szenzorok elsődleges feladata a szabadtér- és az objektumdetekció, azonban a modern kutatások megmutatták, hogy a szenzorok által generált pontfelhők magasabb szemantikai információ kinyerésére is alkalmasak [1]. Ezek alkalmazhatósága azonban korlátos; az objektumok távolsága, a szenzorok felbontása, tárgyak kitakarása, stb. erősen behatárolja a felismerő algoritmusok mozgásterét. Én a különböző korlátozó esetekre javasolok megoldásokat, kiterjesztve ezzel az érzékelők működési tartományát.

A kutatóhely rövid bemutatása

A kutatást a BME-KJK Anyagmozgatási és Logisztikai Rendszerek Tanszékének (ALRT) Járműlátás laborjában és az MTA SZTAKI Gépi Érzékelés Kutatólaboratóriumában végeztem. Az ALRT széles körű profilja a logisztikai folyamatoktól az építő- és anyagmozgató gépek tervezéséig, automatizálásáig terjed. A tanszék járműlátás laborja elsősorban mobilgépek környezetérzékelésével kapcsolatos fejlesztéseket és kutatásokat végez.

A kutatás történetének, tágabb kontextusának bemutatása

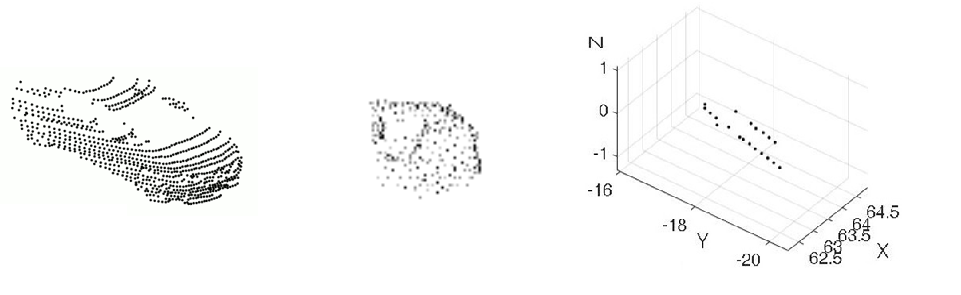

A LIDAR szenzorok által előállított 2.5D pontfelhők működési elvükből adódóan egy bizonyos karakterisztikával rendelkeznek. A mérés eredményeként kapott pontfelhőben a tárgyak sík, vagy síkkal közelíthető metszetekből épülnek fel függőleges irányban. Ez azt eredményezi, hogy a közeli és sűrűn mintavételezett tárgyak esetén alkalmasak objektumklasszifikációra [2]. Azokat az eseteket sem szabad azonban figyelmen kívül hagyni, amikor egy objektum csak részlegesen, vagy csak néhány elkülönülő szegmensen látszik, ugyanis a mozgó gépek miatt a lehető leggyorsabban szükséges döntést hozni. Az 1. ábra azt mutatja, hogy milyen pontfelhőkkel foglalkoztam a kutatásban. A korábbi, teljes objektumalapú megközelítések helyett lokális tulajdonságon alapuló osztályozó módszereket alkalmaztam.

- ábra: Autó képe különböző LIDAR felvételeken, balról jobbra: Velodyne HDL-64E felvétel a Sidney Urban Objects adatszettből [3], részleges pontfelhő és két szkennelési síkból álló pontfelhő (az utóbbi kétféle pontfelhő osztályozásával foglalkoztam)

A kutatás célja, a megválaszolandó kérdések.

A kutatás célja olyan eljárások kifejlesztése volt, amelyek alkalmasak a részleges pontfelhőkből való felismerés problémájának megoldására. A 2D-s képi információ feldolgozása esetében már rendelkezésre álltak ilyen módszerek (ezek több esetben az általam 3D-ben kidolgozott módszerek alapjait jelentették), bizonyos látási körülmények között azonban a kamerákra nem tudunk hagyatkozni, így szükséges a jelen lévő többi szenzort maximálisan kihasználni. A megválaszolandó kérdések közé tartozott, hogy lehetséges-e az olyan tárgyak felismerése, amelyek vagy csak részlegesen vannak jelen a felvételen, vagy esetleg függőleges irányban nem teljesítik a mintavételezési tételt. Ezenkívül olyan gyakorlatibb jellegű kérdések is felmerültek, hogy ha lehetséges, milyen információval egészíthetnénk ki a rendelkezésre álló hiányosakat, és milyen módszerek lehetnek alkalmasak a feladat megoldására.

Módszerek

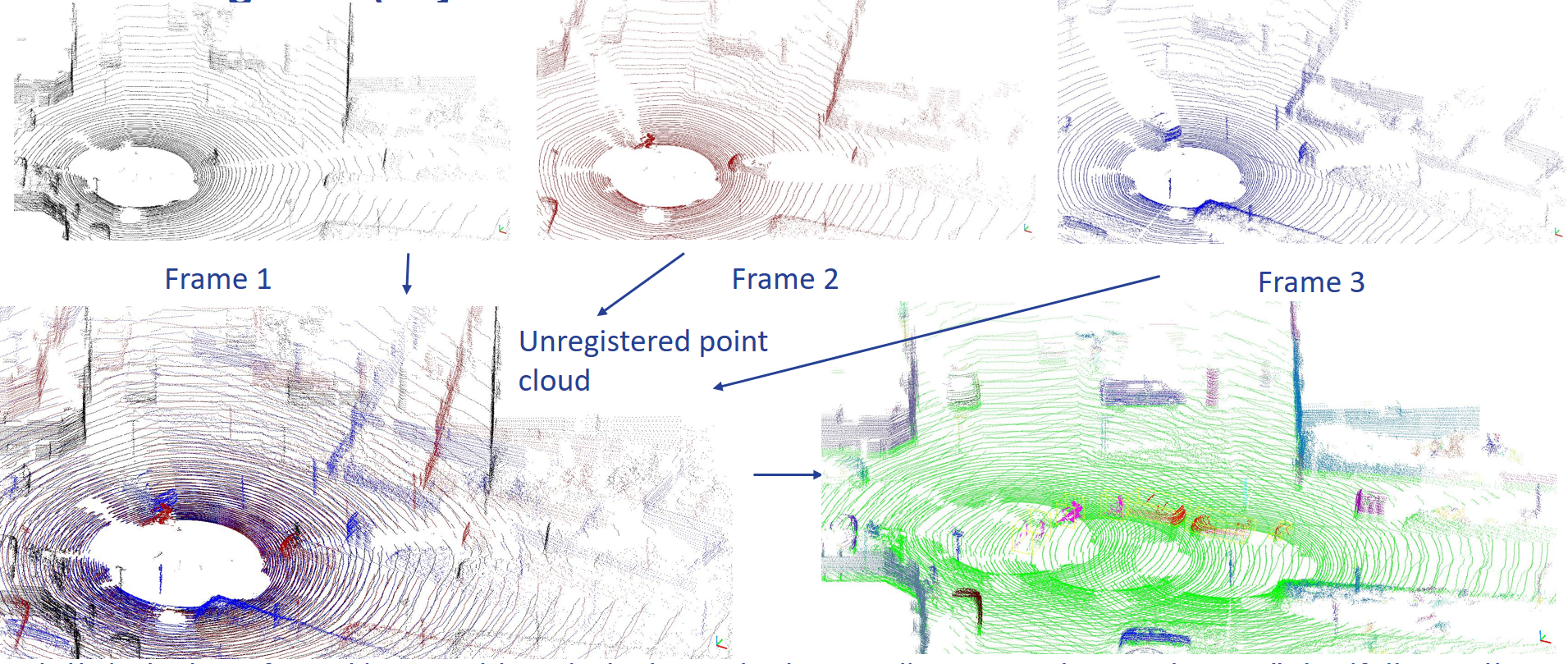

A kutatás során egyrészt a pontfelhő-feldolgozás alapmódszereire építettem. A legfontosabb módszerek, amelyeket az előfeldolgozáshoz használtam: ICP (Iterative Closest Point) [4] a pontfelhők regisztrálásához, MSAC (M-estimator SAmple and Consensus) [5] a talajdetekcióhoz, euklideszi klaszterezés [6] az objektumok elkülönítéséhez, M3C2 (Multiscale Model to Model Cloud Comparison) [7] a változásdetekcióhoz és magyar algoritmus [8] az objektumkövetéshez (2. ábra). Ezenkívül többször merítettem a 2D-s képfeldolgozás módszereiből, illetve továbbfejlesztettem azokat, mint a Harris kulcspont keresés [9], Fourier leíró-alapú alakleírás [10], vagy a Bag of Features-alapú osztályozás [11].

2. ábra: pontfelhő előfeldolgozási módszerek eredménye. A felső sorban három egymás utáni LIDAR-felvétel látható (különböző színnel jelölve), baloldalon alul pedig ezek egymásra helyezve regisztrálatlanul. Jobboldalon alul az előfeldolgozás eredményeként, a pontfelhők és objektumok regisztrálásra kerültek egy globális koordináta rendszerbe, a talajdetekció megtörtént (zöld szín) és a mozgó objektumok is követésre kerültek (egy objektum különböző megjelenései azonos színnel vannak jelölve)

Eddigi eredmények

Az eddig elért legfontosabb eredmények közé tartozik, hogy sikerült kidolgozni két eljárást, ami két szélsőséges esetre nyújt megoldást a LIDAR érzékelés alapú osztályozásban.

Az egyik megoldás arra az esetre vonatkozik, amikor csak részleges objektumokat látunk, azonban függőleges irányban sűrű pontfelhő áll rendelkezésre. Ez elérhető például az egymást követő felvételek regisztrálásával. A tesztek azt mutatják, hogy az eljárással már az objektum nagyon kevés részét (kb. 20 %) ismerve is sokkal pontosabb becslést tudunk adni az objektumosztályra, mint a korábban rendelkezésre álló módszerekkel. A predikciót pedig folyamatosan pontosíthatjuk, ahogy egyre többet fedezünk fel a tárgyból. A módszer kulcspontdetekció és klaszterezés után lokális mintákat definiál, és ezen minták előfordulási valószínűségét használja fel arra, hogy prediktálja a tárgyosztályt.

A 3. ábra arra mutat példát, hogy miként lehet az egymást követő framek regisztrálásával előállítani egy sűrített pontfelhőt, egy adott LIDAR-telepítési konfigurációban; a 4. ábra pedig a regisztrációt mutatja működés közben (először a LIDAR-szenzor által aktuálisan érzékelt 3D környezetet, majd egy globális környezetben regisztrált környezetet), illetve adott lépésszámonként osztályozott objektum kategóriájának változását [S1] [S2] [S3].

3. ábra: LIDAR szegmensből, mozgás közben regisztrált emberi alakot ábrázoló pontfelhő (Forrás: saját felvétel) és egy lehetséges szenzorelhelyezési konfiguráció az előbbi alak előállítására (Forrás: SICK - Efficient solutions for material transport vehicles in factory and logistics automation[1])

4. ábra: Adatregisztráció és akadály- (kerékpáros-) predikció működés közben (a tárgyat 5 lépésben osztályozzuk, a kékkel színezett pontok a prediktált kerékpárososztályt jelölik)

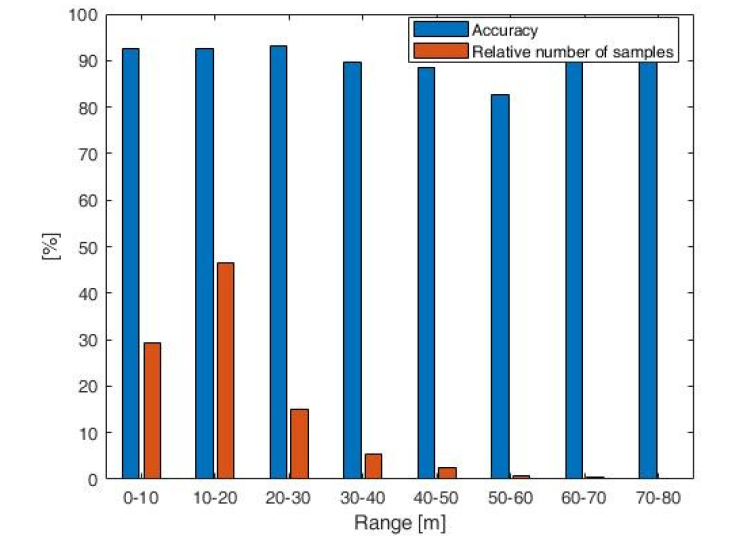

A második kifejlesztett módszer nem követeli meg a framek regisztrálását; ez mindössze néhány LIDAR-szegmensből (vagy akár egyből) is képes prediktálni az objektumkategóriát. A teszteredmények azt mutatják, hogy ezzel a módszerrel akár a hagyományos módszereket is megelőző osztályozási élesség érhető el, ezenkívül olyan esetekben is használható, ahol azok nem. Így sikerült megnövelni a LIDAR-ok detekciós tartományát [S4] [S5]. A módszer alapvetően egy Fourier-alapú leíróból áll, ami figyelembe tudja venni a szegmensek időbeli és térbeli változását, valamint egy a klasszifikációt megvalósító neurális hálót és objektumszintű szavazást tartalmaz. A módszer tesztelése többek között a KITTI adatszetten [12] történt. Az 5. ábra a szenzortól való távolságnak a módszer hatékonyságára gyakorolt hatását mutatja, a 6. ábra pedig egy illusztráció a működéséről.

5. ábra: A módszer eredményessége a szenzortól különböző távolságokra. Jól látható, hogy a pontosság gyakorlatilag távolságfüggetlen (, míg más módszerek a 20-30 m-nél távolabb lévő objektumokat figyelmen kívül hagyják)

6. ábra: A javasolt módszer működés közben; színkód: zöld - autó, kék - kerékpáros. A jó kivehetőség kedvéért sűrű pontfelhőn illusztráltam a módszer működését (ilyen esetekben is a legkorszerűbbel versenyképes eredményeket szolgáltat), emellett nagy előnye, hogy olyan eseteknél is működik, ahol más módszerek nem.

Várható impakt, további kutatás

Az általam kifejlesztett módszerekkel olyan környezetérzékelési problémákra javasoltam megoldásokat, amelyek korábban erősen korlátozták a LIDAR-szenzorok alkalmazhatóságát. A módszereket felhasználva osztályozhatunk mind kitakart, részlegesen látszódó, mind pedig távoli, így rossz vertikális felbontású LIDAR-pontfelhőket. Ez a kutatás jelentősen befolyásolhatja a LIDAR-szenzorok szélesebb körű elterjedését és új feladatokra való alkalmazását, ami előrelendíti az autonóm gépekkel kapcsolatos kutatásokat. A továbbiakban más olyan extrém eseteket is tervezek megvizsgálni, ahol korlátozott a szenzor alkalmazhatósága, pl. szélsőséges időjárási körülmények között.

Saját publikációk, hivatkozások, linkgyűjtemény

Kapcsolódó saját publikációk listája.

[S1] Z. Rozsa; T. Sziranyi, „Exploring in partial views: Prediction of 3D shapes from partial scans”, in: IEEE 12th IEEE International Conference on Control and Automation, ICCA 2016

[S2] Z. Rozsa; T. Sziranyi, „Object detection from partial view street data” in: IEEE 2016 International Workshop on Computational Intelligence for Multimedia Understanding (IWCIM)

[S3] Z. Rozsa; T. Sziranyi, „Obstacle Prediction for Automated Guided Vehicles Based on Point Clouds Measured by a Tilted LIDAR Sensor”, IEEE Transactions on Intelligent Transportation Systems 19 : 8 pp. 2708–2720 , 13 p. (2018)

[S4] Z. Rozsa; T. Sziranyi, „Street object classification via LIDARs with only a single or a few layers”, in: Third IEEE International Conference on Image Processing, Applications and Systems (IPAS 2018), (2018) pp. 1–6, 6 p.

[S5] Z. Rozsa; T. Sziranyi, „Object detection from a few LIDAR scanning planes”, IEEE Transactions on Intelligent Vehicles, in press (2019)

Linkgyűjtemény.

Anyagmozgatási és Logisztikai Rendszerek Tanszék

Hivatkozások listája.

[1] D. Maturana and S. Scherer, “VoxNet: A 3D Convolutional NeuralNetwork for Real-Time Object Recognition,” in IROS, 2015

[2] A. Borcs, B. Nagy, and C. Benedek, “Instant object detection in Lidarpoint clouds” IEEE Geoscience and Remote Sensing Letters, vol. 14, no. 7, pp. 992–996, July 2017.

[3] M. De Deuge, A. Quadros, C. Hung, B. Douillard, “Unsupervised Feature Learning for Classification of Outdoor 3D Scans” in Australasian Conference on Robotics and Automation (ACRA), 2013.

[4] Besl and N. D. McKay, “A method for registration of 3-D shapes” Pattern Analysis and Machine Intelligence, IEEE Transactions in vol. 14, no. 2, pp. 239‑256, Feb 1992.

[5] P. Torr and A. Zisserman, “Mlesac: A new robust estimator with application to estimating image geometry” Computer Vision and Image Understanding, vol. 78, no. 1, pp. 138–156, 2000.

[6] R. B. Rusu, “Semantic 3D object maps for everyday manipulation inhuman living environments,” Ph.D. dissertation, Computer Science department, Technische Universitaet Muenchen, Germany, October 2009.

[7] D. Lague, N. Brodu, and J. Leroux, “Accurate 3D comparison of complex topography with terrestrial laser scanner: Application to therangitikei canyon (n-z)” ISPRS Journal of Photogrammetry and Remote Sensing, vol. 82, no. Supplement C, pp. 10‑ 26, 2013

[8] . L. Miller, H. S. Stone, and I. J. Cox, “Optimizing Murty’s ranked assignment method” IEEE Transactions on Aerospace and Electronic Systems, vol. 33, no. 3, pp. 851–862, July 1997

[9] A. Kovács and T. Szirányi, “Improved harris feature point set for orientation-sensitive urban-area detection in aerial images” IEEE Geosci. Remote Sens. Lett., vol. 10, no. 4, pp. 796–800, Jul. 2013.

[10] J. Cooley, P. Lewis, and P. Welch, “The finite Fourier transform” IEEE Transactions on Audio and Electroacoustics, vol. 17, no. 2, pp. 77–85, Jun 1969.

[11] G. Csurka, C. R. Dance, L. Fan, J. Willamowski, and C. Bray, “Visual categorization with bags of keypoints” in Proc. Workshop Statist. Learn. Comput. Vis. (ECCV), 2004, pp. 1–22.

[12] A. Geiger, P. Lenz, R.l Urtasun, “Are we ready for Autonomous Driving? The KITTI Vision Benchmark Suite”, Conference on Computer Vision and Pattern Recognition (CVPR), 2012